企業における生成AI活用 3つの課題:その解決に向けたAWS技術アプローチと事例を解説

生成AIは企業の業務効率化や付加価値創出に大きな可能性を秘めています。しかし、多くの企業ではPoC(概念実証)で止まり、本格導入に踏み切れない現状があります。その背景には3つの共通課題が存在します。

本記事では、これらの課題をどう整理し、どのように解決へ導くのかを具体事例とともに解説します。生成AIをPoC止まりにさせないための実践的なアプローチを知りたい方に最適な内容です。

■ この記事でわかること

- 生成AI活用がPoCで止まる原因と、企業に共通する3つの課題

- 精度・セキュリティ・推進体制を克服する具体的な解決策とAWSサービス活用例

- サーバーワークスが伴走支援した企業事例と成果

株式会社サーバーワークス

カスタマーサクセス本部 CS4課 課長

村上 博哉2024-2025 Japan AWS Top Engineers (AI/ML Data Engineer)。2020年にAmazon Pollyと出会ったことをきっかけに、前職の市役所職員からサーバーワークスへ転職。機械学習に興味があり、現在は生成AIを中心にお客様の支援を担当。好きなAWSサービスはAmazon SageMaker

保有資格:

2024 Japan AWS Top Engineers (Machine Learning)

2025 Japan AWS Top Engineers(AI/ML Data Engineer)

Machine Learning Specialty / JDLA Deep Learning for Engineer など

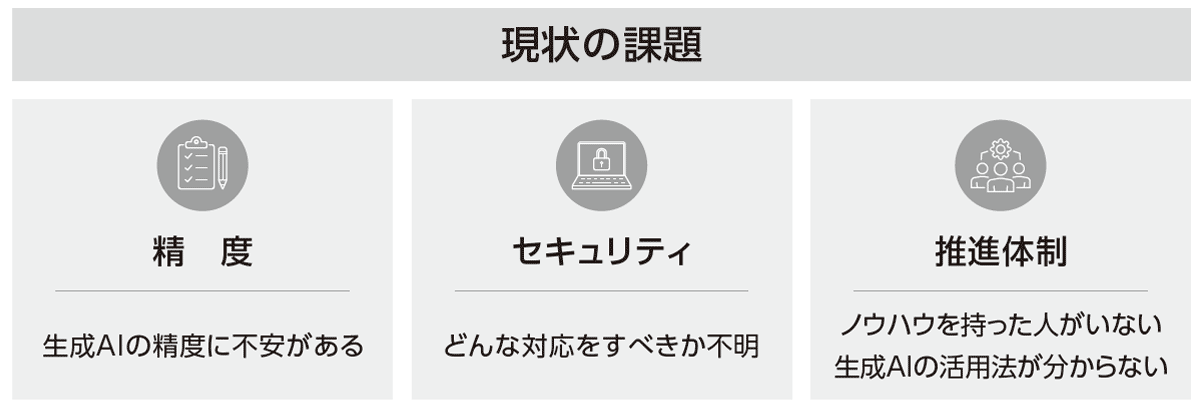

生成AIがPoC止まりになる3つの課題

ChatGPTをはじめとする生成AIが、企業の現場に急速に広がっています。文章生成、翻訳、要約、FAQ対応、レポート作成など、多くの業務でのユースケースが想定され、経営層から現場担当者まで幅広い期待を集めています。特に日本企業においては「人手不足の解消」「業務効率化」「新規事業の探索」といった経営課題と直結するテクノロジーとして注目されています。

しかし同時に、多くの企業が「PoC(概念実証)を行ったものの、その先に進めない」「期待したほど成果が得られず、現場に定着しない」という壁に直面しています。

その背景には、以下の3つの課題が存在します。

- 精度の課題:「もっともらしいが誤った回答」(ハルシネーション)が混じり、安心して業務に使えない

- セキュリティの課題:基盤となるWebアプリ防御と、生成AI特有のリスク対策を両立できていない

- 推進体制の課題:PoC止まりとなり、継続的な改善や内製化に結びつけられない

これらを解決できなければ、生成AIは「一度試して終わる実験」で終わり、事業価値を生み出すまでに至りません。

以下、それぞれの課題を深く掘り下げ、具体的な技術アプローチ、AWSの活用方法、そして当社が支援した実際の企業事例を交えて解説します。

① 精度の課題 :ハルシネーションをどう制御するか

なぜ精度が最大の壁となるのか

生成AIは、大規模言語モデル(LLM)が膨大なテキストを学習し、確率的に次に来る単語を予測して文章を生成する仕組みです。人間のように「意味を理解」しているわけではなく、統計的なパターンをなぞっているに過ぎません。そのため、出力は流暢でも事実と異なる内容が紛れ込む可能性があります。これが「ハルシネーション」と呼ばれる現象です。

たとえば、FAQチャットボットが「存在しない手順」を案内して現場を混乱させる、研究部門で文献を誤引用する、営業現場で法規制に違反する誤情報を顧客に提示するといった事態が、起こり得ます。こうした精度の問題を解決しなければ、生成AIを実務に安心して使うことはできません。

精度を担保するには「評価の仕組み化」が必須

しかし、人間の感覚だけに頼った「便利そう」「ちょっと怪しい」といった評価では、改善のサイクルは回りません。重要なのは、精度を数値で測定し、改善効果を客観的に確認できる仕組みを導入することです。

AWSが提供する評価機能(Amazon Bedrock Evaluations)はその代表例です。

Amazon Bedrock Evaluationsでは、回答を様々な観点で採点します。以下はその一例です。

- 正確性:事実に基づいた答えになっているか

- 完全性:必要な情報が漏れなく含まれているか

- 有害性:誤情報やリスクのある表現を含んでいないか

- ステレオタイプ性:偏見や差別的要素を含んでいないか

この仕組みを使うことで、「改善がどれだけ有効だったか」を数値で把握でき、継続的にチューニングを重ねることが可能になります。

精度を高める具体的な技術アプローチ

推論パラメータの最適化

Amazon BedrockではTemperatureやTop-pなどの推論パラメータを調整できます。情報検索などの用途では低く設定して正確性を高め、アイデア創出など回答に多様性を求める場合は高めに設定するというように、ユースケースごとに適切なパラメータを選ぶことで、精度と利便性のバランスを取れます。

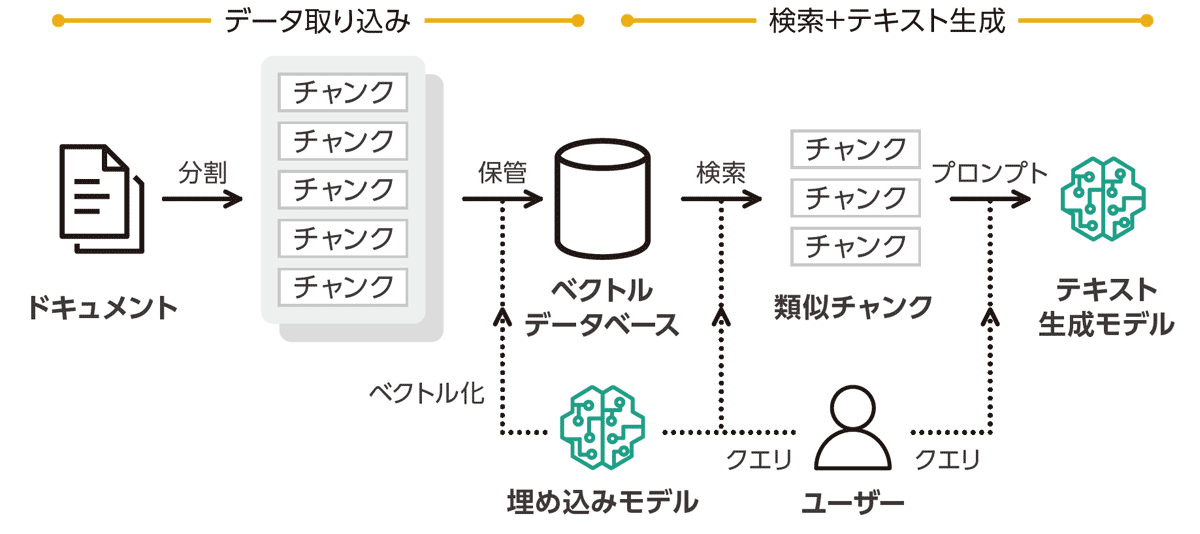

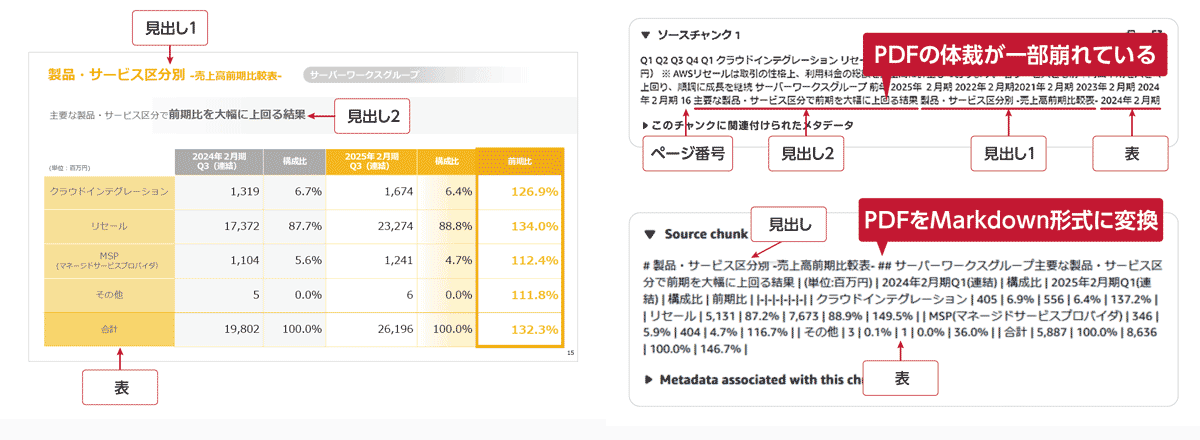

階層的チャンキング

Amazon Bedrock Knowledge Basesで利用可能な階層的チャンキングは、文書を小さく分割して検索精度を高めつつ、生成AIモデルには広範な文脈を入力します。 これにより「断片的すぎる回答」を防ぎ、文脈に沿った一貫した出力が可能になります。

基盤モデルを用いたパース

基盤モデルを利用して画像や図表を含むPDFなどのマルチモーダルデータを解析します。 これによりAIが表の構造を正しく理解できるようになり、複雑なマニュアルや資料でも誤答が減り、信頼性が向上します。

「精度」 の課題 解決のポイント

このように、精度改善は「一度やれば終わり」ではなく、モデル更新や業務変化に合わせて継続的に取り組む必要があります。RAG評価のような仕組みを導入し、改善を数字で追い続ける文化を作ることが不可欠です。

② セキュリティ の課題 :「責任あるAI」をどう実現するか

セキュリティ対策は段階的に進めることが重要

生成AI導入では「セキュリティは大丈夫か?」という懸念が必ず出ます。対応を誤れば情報漏えいやブランド毀損につながり、導入自体が止まってしまうケースも少なくありません。だからこそ、場当たり的に対策を重ねるのではなく、段階的に整理して進めることが欠かせません。

まずは一般的なWebアプリケーションのセキュリティを確認する

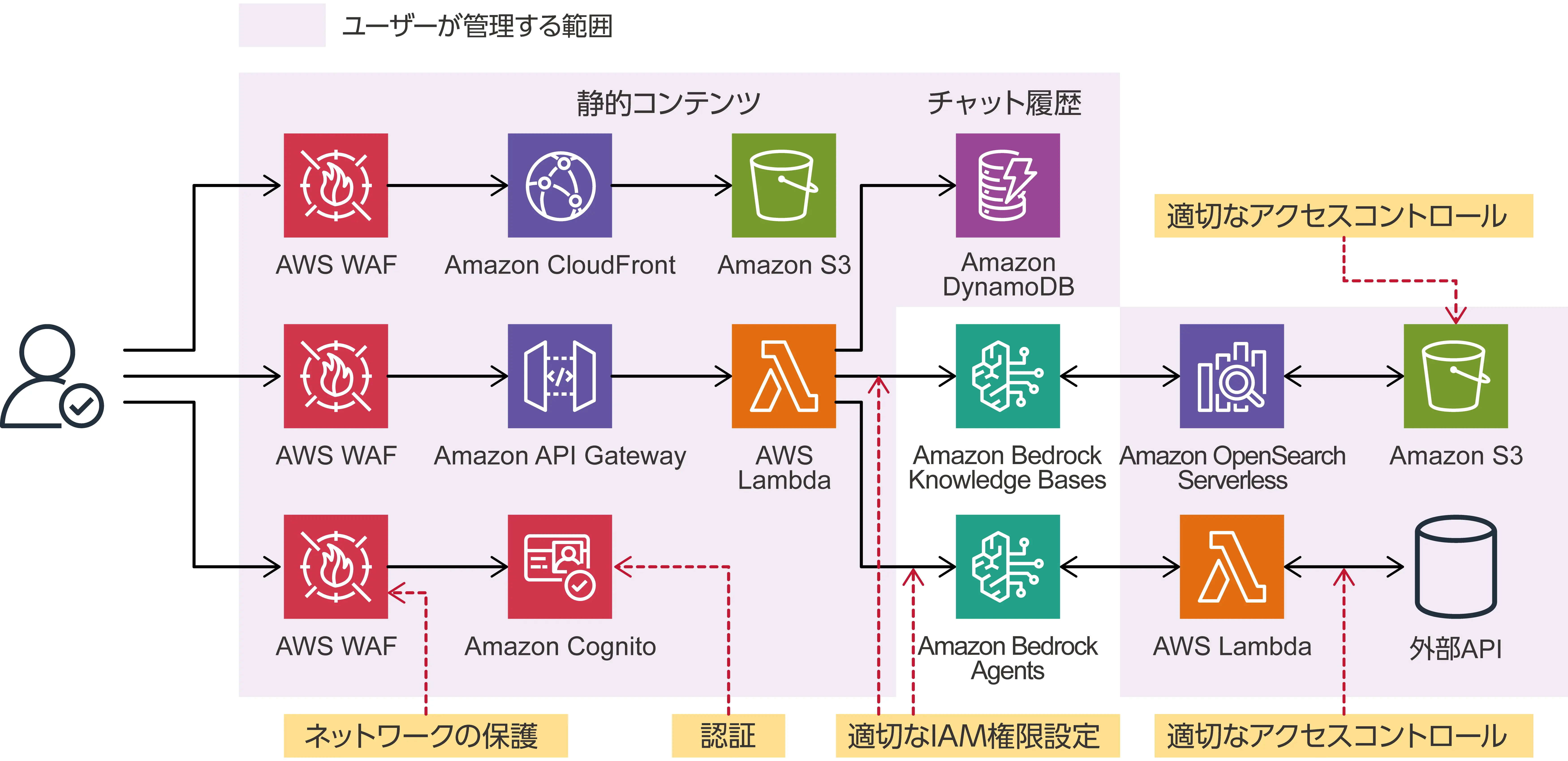

生成AI特有のリスク対策を検討する前に、企業はまず「通常のWebアプリケーションとして必要なセキュリティがきちんと実装されているか」を振り返る必要があります。これはAWS Well-Architected Frameworkのセキュリティの柱に沿って整理できます。

主な対応と利用サービス

- 認証・認可の徹底: AWS Identity and Access Management / AWS IAM Identity Center / Amazon Cognito

- ネットワーク分離: Amazon VPC / AWS PrivateLink / AWS WAF

- データ暗号化と鍵管理: Amazon S3 / AWS Key Management Service

- ログ監査と異常検知 : AWS CloudTrail / Amazon GuardDuty / AWS Security Hub / AWS Config

これらが未整備では、生成AI以前にシステム全体が危険にさらされる可能性があります。したがって、まず基盤のセキュリティを確実に固めることが出発点です。

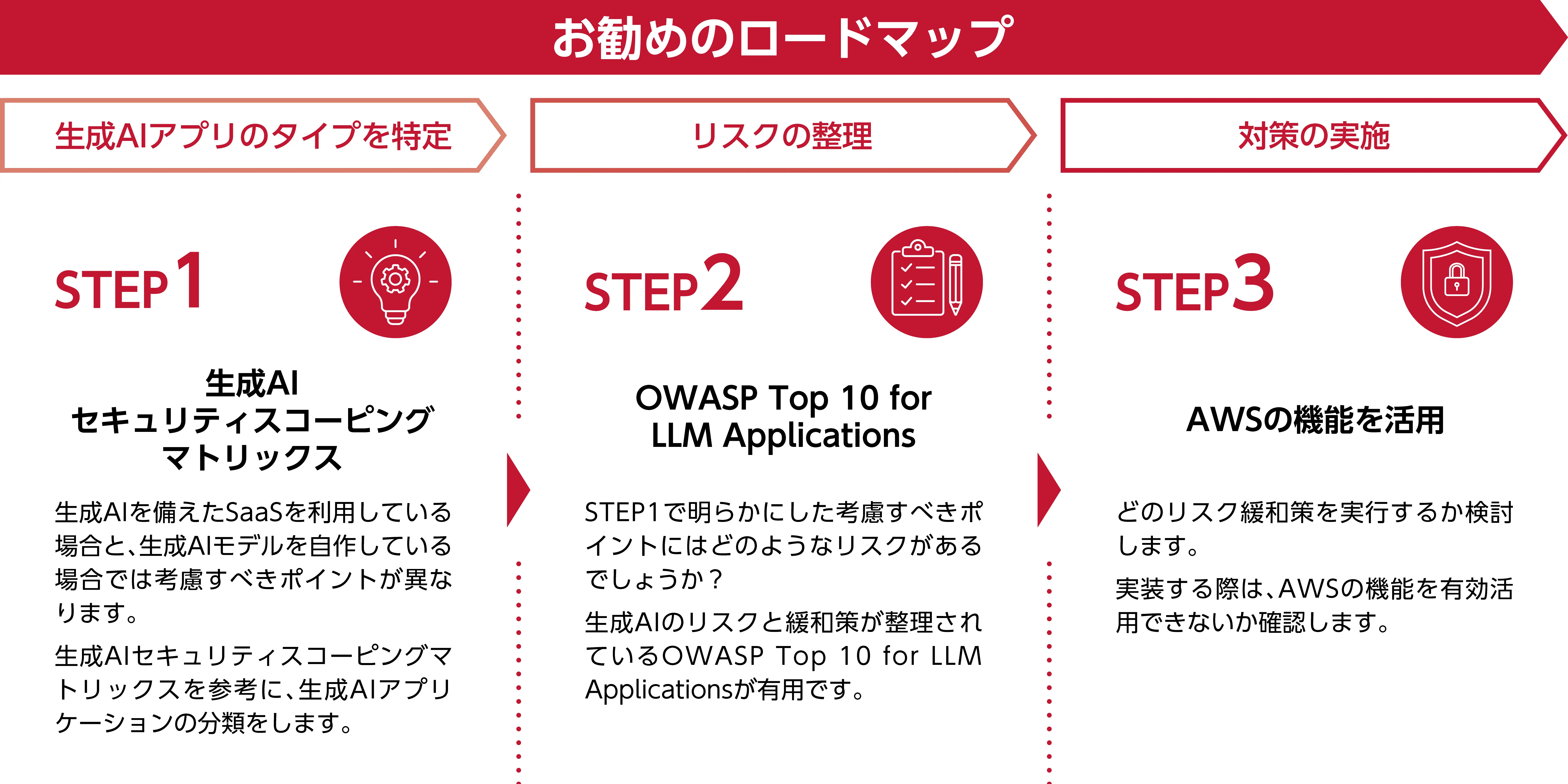

サーバーワークスが推奨する3ステップのロードマップ

その上で、サーバーワークスは以下の 3ステップロードマップ を推奨しています。

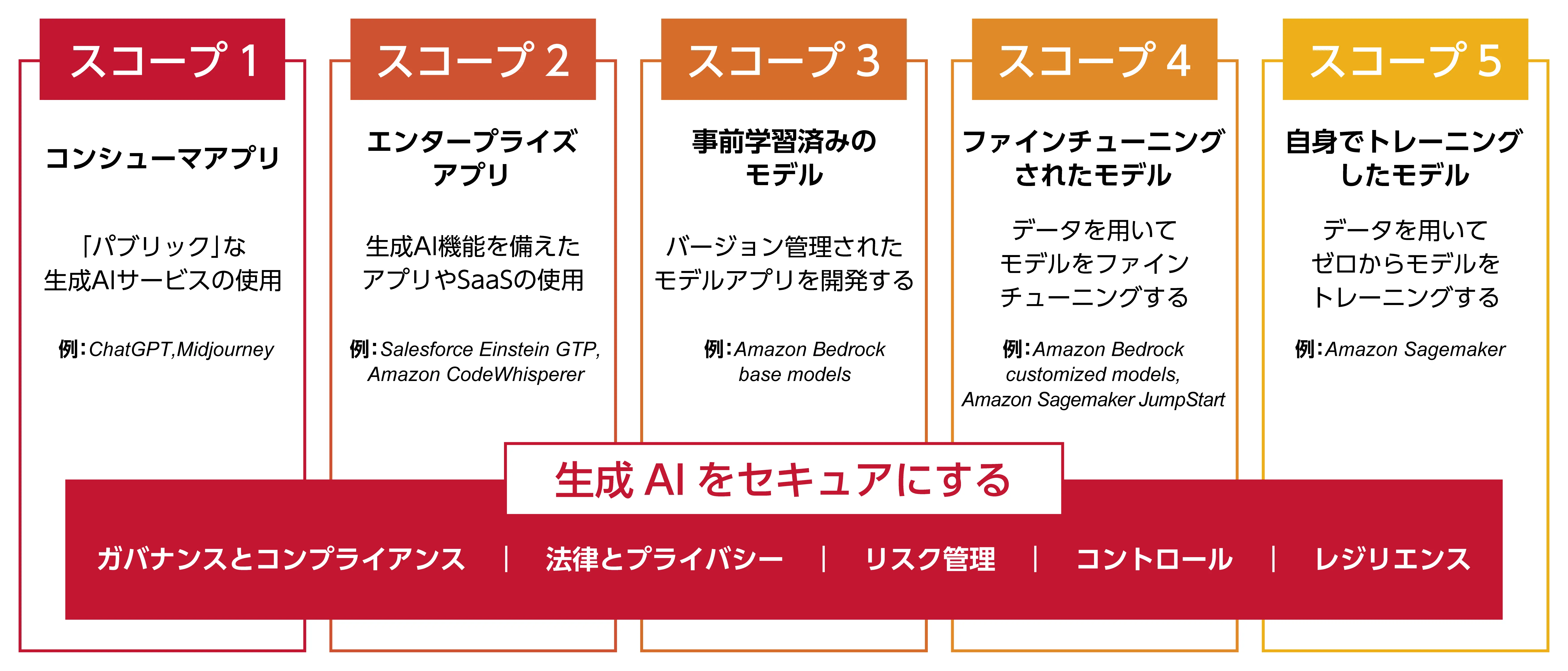

Step1|生成AIセキュリティスコーピング(守る範囲を定義する)

まず「どの生成AIアプリを対象とし、どこまでを自社の責任で守るのか」を整理します。これは「生成AIセキュリティスコーピング」と呼ばれる考え方です。

- モデルそのものは Amazon Bedrock がマネージドで運用するため直接管理は不要

- 一方で、入力データや参照する社内コーパス、ユーザー認証やネットワークは自社が責任を持つ領域

こういった点を曖昧にせず、担う部分を切り分けることで、議論の混乱を避けられます。守る範囲を明確にしてからリスク整理と対策実施へと進むことで、効率的かつ抜け漏れのないセキュリティ対策が可能になります。

※AWSブログ「生成 AI をセキュアにする: 生成 AI セキュリティスコーピングマトリックスの紹介」より引用

https://aws.amazon.com/jp/ai/generative-ai/security/scoping-matrix/

Step2|リスクを整理する(タイプ別に洗い出す)

タイプが特定できたら、次に想定されるリスクを洗い出します。

チャットボット型

- リスク:プロンプトインジェクション、不適切出力

- 例:限定公開資料を誤って回答に含めてしまう

RAG型

- リスク:誤情報や古い情報を含むコーパスを参照、権限外ドキュメントを利用

- 例:限定公開資料を誤って回答に含めてしまう

業務自動化型

- リスク:権限逸脱による誤処理、業務フロー暴走

- 例:想定外のアクションをAIが自動実行してしまう

この段階で「どのリスクを重点的に潰すか」を明確化し、AWS CloudTrail・Amazon GuardDuty・AWS Security Hub・AWS Config などの監査機能を組み合わせて、検証ポイントを定義します。

Step3|対策を実施する(基盤+AI特有+継続改善)

整理したリスクに対して、実際のセキュリティ対策を講じます。ここでは「基盤としての一般的な防御」と「生成AI特有のリスク対策」を組み合わせ、さらに改善を継続できる仕組みを整えることが重要です。

基盤防御

- AWS IAM Identity Center で認証と権限管理を統一し、アクセスを厳格に制御。

- Amazon Virtual Private Cloud(Amazon VPC) と AWS PrivateLink を利用し、外部から直接アクセスできない閉域環境を構築。

- Amazon Simple Storage Service(Amazon S3) のデータは AWS Key Management Service(AWS KMS) によって暗号化し、機密情報の漏洩を防止。

- AWS CloudTrail による操作ログの記録と Amazon GuardDuty の脅威検知で、不正な挙動を早期に発見。

生成AI特有の対策

- Amazon Bedrock Guardrails を設定し、不適切な回答やポリシー違反となる出力を防止。

- Amazon Comprehend を利用して入力テキストから個人情報(PII)を検出し、必要に応じてマスク処理を行う。

継続的な改善

- AWS Security Hub でセキュリティ状態を一元的に把握し、リスクを集約

- AWS Config によって設定の逸脱を常時監査し、ポリシー違反を検出

- さらにAmazon Bedrock Evaluationsを用いて、回答の「正確性・完全性・有害性・偏り」を定点観測し、改善を繰り返す

このように段階を踏むことで、多層防御を実現できます。これにより「PoCの段階で危険だから止める」のではなく、「安全性を確認しながら導入を前に進める」体制を築くことが可能になります。

「セキュリティ」の課題 解決のポイント

セキュリティは基盤防御とAI特有リスク対策を二層で構築し、責任分界を明確にした上で継続的に監査・改善を回すことが重要です。

③ 推進体制 の課題 : PoC止まりを防ぎ、内製化へ進む

なぜPoCで止まるのか

生成AIのPoCを実施した多くの企業で、その先に進めず停滞する例が多発しています。背景には以下のような要因があります。

- 経営層の視点:成果が「便利そう」「面白い」といった感覚に留まると、投資判断を下せません。ROIやリスク低減効果を示す数値データが不足しているため、承認が先送りされます。

- 現場ユーザーの視点:PoC段階で誤答が多いと「実務で安心して使えない」と判断し、利用をやめてしまう。現場に定着しないまま「結局従来通りのやり方で進める」流れに戻ってしまいます。

- IT部門の視点:短期PoCはセキュリティやガバナンスが整っていない場合が多く、「このままでは本番展開できない」と判断。IT部門がストッパーになり、PoC止まりで終わります。

このように、PoCが停滞するのは「成功の定義が曖昧」「評価指標が欠如」「改善サイクルが設計されていない」ことが根本原因です。

推進の仕組み : 短期サイクルPoC

サーバーワークスはPoCを単発で終わらせず、短期サイクルで回す仕組みを設計します。

1.ゴール設定

- 具体的に「誰の業務を、どの指標で、どの程度改善すれば成功か」を定義

例:問い合わせ対応の削減率30%、営業資料作成工数50%削減、顧客満足度スコア+10ポイント など 経営層も「成功の姿」を理解できるため、承認しやすくなります。

2.プロトタイピング

- Amazon BedrockやGenU、Amazon Q Businessのようなノーコードツールを活用し、1〜3か月で動くものを構築

- 短期で現場に触れてもらい、週単位で改善要望を収集

完成度ではなく「改善の叩き台」としてスピードを重視します。

3.評価

- Amazon Bedrock Evaluationsを使い、AI回答の「正確性・完全性・有害性」をスコア化

- 業務KPI(問い合わせ件数削減、処理時間短縮、生産性向上)と組み合わせて効果を測定

数字を根拠に経営層を説得し、次のステップへ進めます。

「推進体制」の課題 解決のポイント

PoCは「試したら終わり」の実験ではなく、「短期で回し続ける改善文化」を社内に根づかせるプロセスです。 そのためには、ゴール設定 → プロトタイピング → 評価 の仕組みを制度化し、経営層・現場・IT部門を巻き込むことが不可欠です。これを定着させた企業は、PoC止まりから本番導入、さらに内製化へと進むことができます。

サーバーワークスの支援

生成AIを業務に定着させるには、技術検証だけでなく「成果を数値で示し、社内に知見を残す」プロセスが不可欠です。サーバーワークスはAWS専業のクラウドインテグレーターとして、短期のPoCから本番導入、内製化までを一気通貫で伴走します。

■ 提供する主な支援

1) PoC伴走支援(約3か月)

- 目的:

- 短期で検証サイクルを回し、PoC止まりを回避する。

- 提供内容:

- プロトタイプ構築支援、KGI/KPIの数値化支援、評価

- 効果:

- 改善効果を数値で可視化でき、次の判断(本番導入/改善継続)が明確に。

2) Generative AI Use Cases JP (GenU)

- 目的:

- 低コスト・短期間でPoCを立ち上げる。

- 提供内容:

- AWS公式のサンプルアプリを活用し、実ユースケースに近い形で迅速にプロトタイプを構築。

- 効果:

- 初期費用を抑えつつ、スピーディに検証を開始できる。

3) RAG評価の設計・運用支援

- 目的:

- AI回答の品質を定量的に測定し、改善を継続できる体制をつくる。

- 提供内容:

- 正確性・完全性・有害性・ステレオタイプ性を含む評価基準を策定し、スコアリング手法を整備。

- 効果:

- 主観ではなく客観指標で改善効果を把握でき、導入判断の精度が上がる。

4) ワークショップ(情報+実践)

- 目的:

- 情報と経験の両輪を回し、推進体制を強化する。

- 提供内容:

- 最新の事例・技術の紹介に加え、自社業務への適用アイデアを実際に検討。

- 効果:

- 社内の理解と合意形成が進み、現場が前進する最初の一歩を明確にできる。

5) Well-Architected Framework(WAF)セキュリティレビュー

- 目的:

- 生成AI以前に必要な「基本的なWebアプリのセキュリティ対策」を確認する。

- 提供内容:

- 認証/認可、ネットワーク分離、ログ監視、暗号化などをAWS WAFの「セキュリティの柱」に沿ってレビュー。必要に応じてスコーピングマトリクスやAudit Managerも活用。

- 効果:

- 基盤セキュリティを固めたうえで、生成AI特有のリスク対策に進める。

6) AWSトレーニング・内製化支援

- 目的:

- 生成AI活用に必要なAWSサービスの基礎理解と実践的スキルを習得する。

- 提供内容:

- Bedrock・Kendra・Textractなど、生成AI活用に関わる主要サービスを題材に、ハンズオン形式で汎用的なAWSの運用知識を身につける。

- 効果:

- 自社での活用を自走できるスキルを獲得し、次のフェーズ(RAG運用支援・生成AI PoC支援)への展開をスムーズに進められる。

サーバーワークスは「小さく早く試す」「成果を数値で示す」「知見を社内に残す」を三位一体で伴走します。短い検証サイクルを仕組み化し、PoC止まりを防ぎ、本番活用と内製化へ確実につなげます。

まとめ

生成AIの活用は、精度・セキュリティ・推進体制という三つの課題を切り離して考えるのではなく、一体で解決してこそ成果につながります。サーバーワークスは実際に、精度評価や多層防御のセキュリティ設計、短期PoCサイクルを通じて導入企業の不安を解消し、経営層の承認を獲得してきました。

PoCで立ち止まるのではなく、本番導入を成功させたい企業にとって、確かな伴走支援こそが次の一歩を切り拓く鍵となります。

生成AIの業務活用でお悩みの方は、ぜひサーバーワークスにご相談ください。